大規模言語モデル(LLM)は、ますます多くの分野で活用されていますが、モデル自体が持つ知識に限界がある場合や、より最新かつ専門的な情報を利用したいときには、RAG(Retrieval Augmented Generation)のような技術が重要な役割を果たします。さらに、外部のツールや知識を統合するAugmented Language Modelsも、LLMの性能を大幅に向上させる方法の一つです。

この記事では、RAGとAugmented Language Modelsの仕組み、活用法、さらには最新技術の実例について解説していきます。

RAG(Retrieval Augmented Generation)の概要

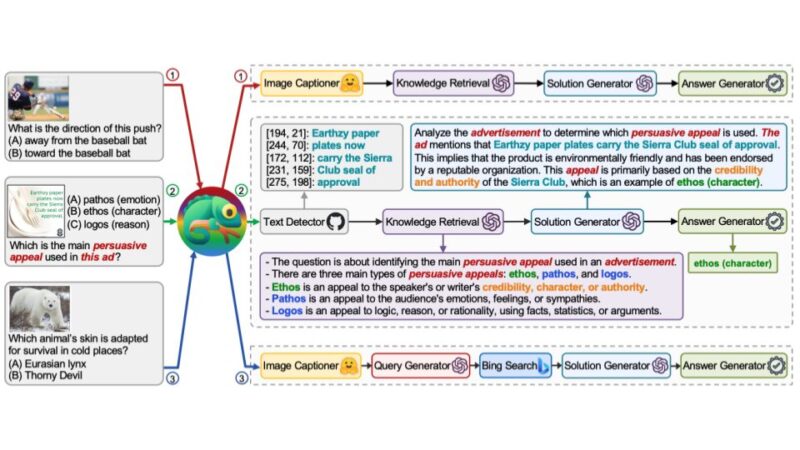

RAG(Retrieval Augmented Generation)は、言語モデルが外部の知識を利用して回答を生成する手法です。

RAGの基本的なアイデアは、まず関連する外部情報を検索し、それを基に生成されたテキストを使って応答を作成することにあります。

この手法により、モデルは静的な知識に頼るだけでなく、外部の最新情報や専門的なデータにアクセスできるため、より正確で高度な回答が可能になります。

主な役割: 外部データベースからの情報検索とそれを基にした応答生成。

使用例: 最新のニュース、技術動向、専門的な研究成果を含むデータの取得が必要な場合

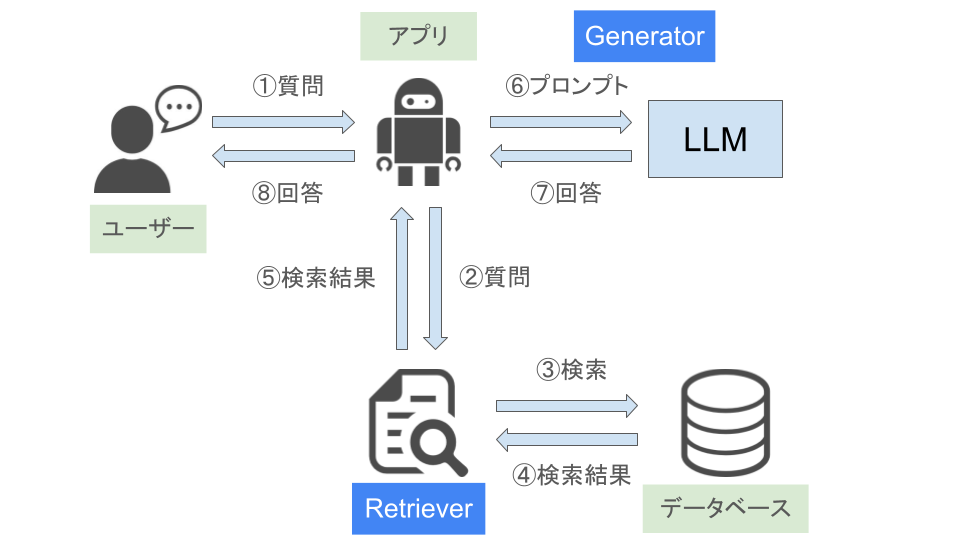

RAGの仕組み

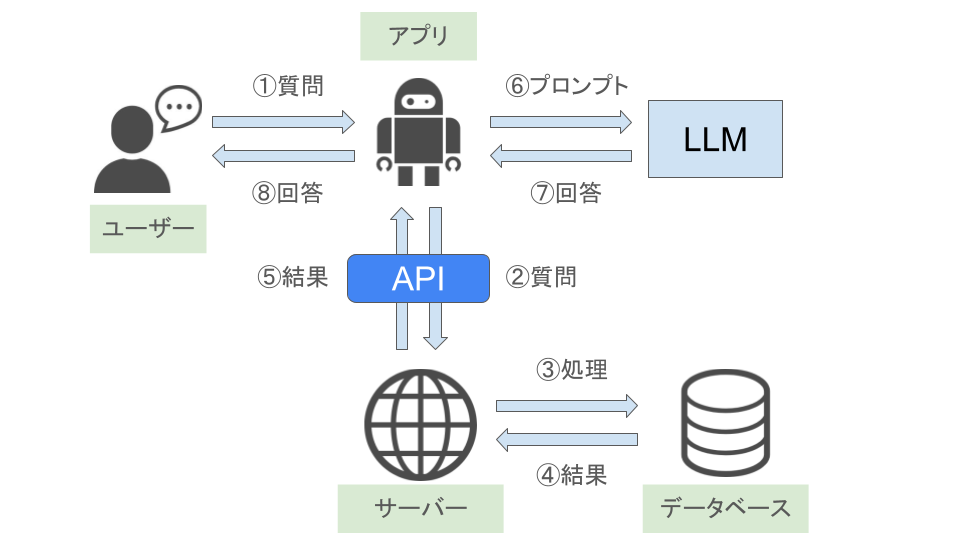

RAGの流れは、まず外部データベースから関連する情報を検索し、その結果を基に応答を生成するという2段階のプロセスです。RAGは検索(Retriever)と生成(Generator)の2つのコンポーネントで構成されており、主に情報検索に特化しています。

- Retriever: 最初に、モデルが関連する外部情報を検索します。この外部情報は、インターネット上の公開データベースや、企業の内部データベースなど、様々なソースから取得されます。

- Generator: 次に、検索された情報を基に、モデルがテキストを生成します。これにより、モデルは単なるデータ検索にとどまらず、検索結果を基に高度なテキスト生成を行い、より信頼性の高い回答を提供します。

Sparse RetrieverとDense Retriever

RAGでは、外部情報の検索方法としてSparse RetrieverとDense Retrieverの2つのアプローチがあります。

- Sparse Retriever: これは従来の検索手法で、キーワードマッチングに基づいて検索が行われます。簡易的な検索ですが、大量のデータから重要な情報を素早く取得することが可能です。

- Dense Retriever: より高度な検索手法で、検索クエリと情報ソースの両方をベクトル化し、埋め込み空間内で類似度を計算します。これにより、単純なキーワードではなく、文脈に基づいた関連情報を見つけることができ、精度の高い検索が可能となります。

RAGのメリット

RAGの最大の利点は、モデルが自身の訓練データに依存せず、常に最新の外部データにアクセスできる点にあります。特に次のような状況でRAGは有効な手法となります。

- 最新情報が必要な場合: モデルが訓練された後に発生した事象や最新のデータに基づいて回答する必要がある場面。

- 専門的な知識を活用したい場合: 専門的な領域で深い知識が求められるタスクにおいて、外部の専門データベースを活用することで、より精度の高い回答を生成できます。

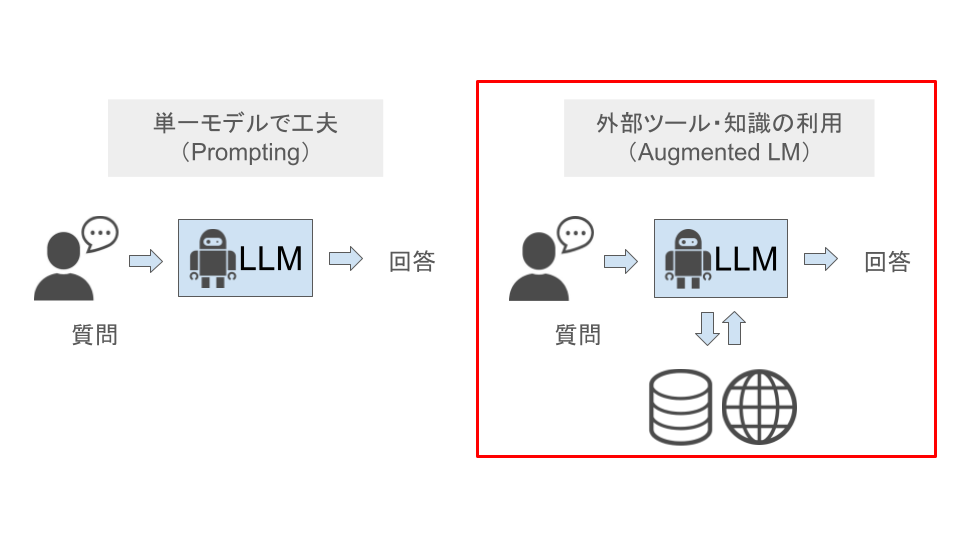

Augmented Language Models(ALMs)の概要

Augmented Language Models(ALMs)は、外部ツールや知識ソースを活用して、モデルの能力を強化する手法です。

LLMは膨大な情報を基に訓練されているものの、外部の最新情報やツールを活用することで、さらなる性能向上が期待できます。

Augmented Language Modelsは、モデルの内的知識に加えて、外部リソースを柔軟に利用することができ、特に情報検索やデータベースアクセス、API連携などを通じて、より正確で信頼性の高い応答を提供します。

主な役割: 外部ツールとの統合による高度なタスク処理やリアルタイムデータの活用。

使用例: 科学的なシミュレーション、統計的なデータ解析、リアルタイムの株価計算や翻訳タスク。

Augmented Language Modelsの仕組み

ALMsは、LLMが外部ツールやAPIを通じて外部の計算リソースやデータにアクセスし、その結果を応答に反映させる仕組みです。ALMsは、外部ツールとの連携を中心にしており、計算や翻訳、シミュレーションなどのタスクを実行できます。

- 情報検索: モデルが外部のデータベースやインターネットから必要な情報を検索し、回答の生成に活用します。これは、RAGとも類似しているプロセスです。

- 外部ツールの利用: モデルが計算ツール、翻訳ツール、さらには専門的なシミュレーションツールなどを利用して、モデル自体の能力を補完します。

Augmented Language Modelsのメリット

- 汎用性の向上: 内部知識に加えて、最新の情報や外部ツールを利用することで、より多様なタスクに対応できます。

専門性の強化: 外部の専門知識やツールを利用することで、特定の分野でのモデルの専門性を強化し、より精密な回答を提供します。

RAGとAugmented Language Modelsの比較

RAGとAugmented Language Models(ALMs)は、どちらもLLMの性能を拡張する技術ですが、それぞれ異なる目的や手法を持っています。

RAGは、LLMが訓練データに依存せず、外部のデータソースから最新の情報を取得し、その情報を基に応答を生成する技術です。

一方、ALMsは、外部ツールやAPIと連携することで、LLMが高度なタスク(計算、翻訳、シミュレーションなど)を実行できるようにする技術です。

RAGとALMsの違いを比較すると下記表のようになります。

| 特徴 | RAG(Retrieval Augmented Generation) | ALMs(Augmented Language Models) |

| 主な役割 | 外部データの検索と応答生成 | 外部ツールやAPIと連携してタスクを処理 |

| 処理フロー | 検索→応答生成 | 外部ツールで処理→応答生成 |

| 適用範囲 | 最新情報や知識の取得、専門分野の情報検索 | 高度な計算やシミュレーション、翻訳タスク |

| 使用例 | 最新の研究論文や法律判例の検索 | 数式計算、リアルタイム分析、翻訳業務 |

| メリット | 訓練データに依存せず、常に最新の情報を活用できる | 外部リソースとの連携で高度なタスクが処理可能 |

RAGとAugmented Language Modelsの応用例

RAGとAugmented Language Modelsは、以下のような場面で広く応用されています。

1. ニュースや金融データの処理

最新のニュースや市場の動向を把握し、これに基づいた分析を行う際、RAGを活用することで、モデルは訓練データに依存せず、常に最新のデータに基づいて推論を行います。特に金融業界では、瞬時に変動する市場情報を取り込み、分析結果を生成するためにRAGが重要です。

2. 医療データの活用

医療分野では、膨大な研究論文や診断データが日々更新されています。RAGを活用することで、モデルは最新の医療情報にアクセスし、患者に対してより正確な診断や治療提案を行うことができます。また、Augmented Language Modelsを使用して専門的なツールと連携することで、複雑なシミュレーションや計算を伴う医療タスクにも対応可能です。

3. 顧客サポートの自動化

顧客サポートでは、ユーザーからの問い合わせに対し、個別のニーズに応じた回答が求められます。RAGとAugmented Language Modelsを組み合わせることで、モデルは製品データベースやFAQから情報を検索し、ユーザーごとにカスタマイズされた回答を提供できます。

RAGとAugmented Language Modelsの将来展望

RAGとAugmented Language Modelsの技術は、今後さらに多様な分野での応用が期待されています。特に、次のような領域での進化が注目されています。

1. リアルタイムデータの統合

現在、RAGは主に静的なデータベースを活用していますが、今後はリアルタイムで更新されるデータソースとの統合が進むと考えられています。これにより、瞬時に変化する情報に基づいて、リアルタイムな応答が可能になります。

2. 外部ツールとのシームレスな連携

Augmented Language Modelsでは、現在もさまざまな外部ツールを利用していますが、今後はより高度なツールやAPIとのシームレスな連携が進むと予想されます。例えば、モデルが自動的に高度な分析やシミュレーションを行うツールと連携し、より高度な問題解決を行うことが可能になるでしょう。

まとめ

RAGとAugmented Language Modelsは、言語モデルが持つ限界を超えて、より高精度かつ柔軟にタスクをこなすための強力な手法です。

外部情報を検索・利用するRAGと、外部ツールを組み合わせて能力を強化するAugmented Language Modelsにより、LLMはこれまで以上に幅広い分野で活躍できるようになりました。

今後もこれらの技術の進化により、LLMはより多くのタスクや分野で革新をもたらすことが期待されます。